אודות מגזין הניהול של הרווארד (HBR)

מגזין הניהול של אוניברסיטת הרווארד יוצא לאור מזה מאה שנה ומאגד מאמרים מבוססי מחקר ונתונים. עם כותביו נמנים מיטב המומחים הבינלאומיים לניהול ולעסקים במגוון תחומים, ובהם מנהיגות, משא ומתן, אסטרטגיה, שיווק, כספים ותפעול. מאמרי Harvard Business Review מתורגמים ומתפרסמים בגלובס שלוש פעמים בשבוע: בימים שני, רביעי וחמישי (מגזין G).

אודות הכותבים

אג'יי אגרוול, ג'ושוע גאנס ואבי גולדפרב הם פרופסורים בבית הספר לניהול על שם רוטמן באוניברסיטת טורונטו.

תוכנות בינה מלאכותית (AI) הן מכונות ניבוי. הן יכולות לומר מה הסבירות שהיום ירד גשם, אך הן לא יאמרו לכם אם לקחת מטרייה. מכיוון שתחזית לא מספיקה להחלטה על מטרייה - אם הסבירות לגשם היא 10%, חלק מהאנשים יבחרו לקחת מטרייה, אבל אחרים לא. יש אנשים שהרבה יותר מפריע להם להירטב. קבלת ההחלטה הזאת מצריכה ניבוי אבל גם שיפוט המבוסס על ההעדפות שלכם.

● HBR | שלוש אסטרטגיות שיהפכו את תוכניות המנטורינג בארגונים למועילות

● HBR | כך העסקת אנשים עם מוגבלויות תסייע לארגון שלכם לבנות יתרון תחרותי

● HBR | אמון הצרכנים במפתחי טכנולוגיה הולך ונשחק. כך חברות יכולות לשנות זאת

כמובן, יש החלטות רבות שאנו יודעים מה ההשלכות שלהן או יכולים בקלות לחשב אותן. בעיקרון, אנו יודעים מה נהג צריך לעשות ברוב המצבים - להאיץ, לבלום, לפנות - מכיוון שאנו יודעים מה ההשלכות של לא לעשות את הדבר הנכון. אבל בקשו מגוגל עצה לגבי מדיח כלים חדש, והמקסימום שהוא ידע לעשות הוא לחזות באילו עמודי אינטרנט כנראה תמצאו את המידע. הוא לא יגיד לכם מה לעשות. בדומה, בעוד שאולי תחששו שהמעסיק שלכם ייעזר ב־AI כדי להחליט אם כדאי לפטר אתכם, המכונה היא לא זו שאחראית בסופו של דבר. AI עשויה להציע תחזית לגבי הביצועים שלכם, אבל המעסיק הוא שמפעיל שיפוט ומחליט את מי לפטר.

מהנדסי פונקציית תגמול

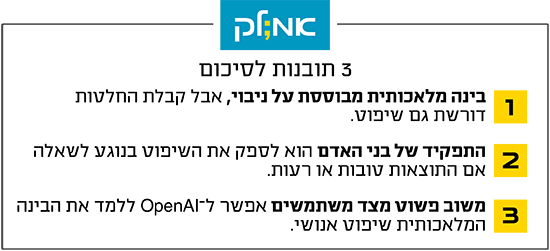

לכן בספרנו מ־2018 Prediction Machines זיהינו תפקיד למהנדסי פונקציית תגמול: לקבוע מה התגמול על פעולות שונות, בהינתן הניבוי של ה־AI. תחזיות AI יכולות לשפר החלטות רבות, ומהנדסי פונקציית תגמול שיבינו את התחזיות ואת ההחלטה שעל הפרק יספקו השלמה מיומנת. אך חדשנות בהנדסת פונקציות תגמול כאלה הייתה איטית.

עד לאחרונה מודלים גדולים של שפה, חרף בינתם לכאורה, היו רק מכונות ניבוי. אך הם משנים את הדרך שבה AI מסייעת לקבל החלטות, משום שהם משנים את הדרך שבה בני אדם מספקים הערכות שיפוטיות.

אם תבקשו מ-ChatGPT לשכתב פסקה כך שתהיה נהירה יותר לקהל מסוים, הוא לא יספק אפשרויות או הרצאה על דקדוק ורטוריקה, הוא ייתן לכם פסקה. זה מרשים, אבל הנס האמיתי הוא ש-ChatGPT יכול לכתוב את הפסקה שרציתם. בכתיבת פסקה יש המון סוגיות של תגמול וסיכון. האם הכתיבה תהיה כנה (תואמת לעובדות), לא מזיקה (לא כוללת מילים פוגעניות) ומועילה (תשיג את המטרה)?

המודלים מאומנים על כתיבה קיימת של בני אדם. הפסקה המופקת, במהותה, נכתבת בסוג של השלמה אוטומטית שוב ושוב. כשאנו נותנים לטלפונים להשלים את ההקלדה, הם עושים עבודה טובה אך לא מושלמת. אז איך ChatGPT מצליח להפיק תוצאות כל כך הרבה יותר טובות מהאדם הממוצע? איך הוא מסוגל לשפוט איכות מכל התוכן, הטוב והרע, שעליו אומן? למה לא הפך לביב שופכין רעיל, כפי שקרה לצ'טבוט Tay של מיקרוסופט אחרי יום אחד בלבד בטוויטר?

יש אנשים, כמו סטיבן וולפרם, שמאמינים כי מודלים גדולים של שפה חושפים כמה כללים בסיסיים של דקדוק. נכון, זה יכול להפוך את הכתיבה לניתנת לקריאה, אבל זה לא הופך אותה לבהירה ומושכת.

כשקל לדבר עם המכונה

מאמר של חוקרים ב־OpenAI מ־2022 מספק רמז חשוב, ומתאר כיצד השתמשו במודלים גדולים של שפה במצבם הגולמי להפקת פלט לאנשים אמיתיים. האנשים התבקשו לדרג כמה תוצאות שונות של אותן הוראות (פרומפט). הקריטריונים הוגדרו במדויק (למשל להעדיף עזרה, כנות ואי־גרימת נזק). מתברר שבעזרת הוראות ברורות ומעט הכשרה אנשים שונים הסכימו על הדברים האלה בקלות יחסית.

הדירוגים שימשו לאחר מכן כדי לכוונן את האלגוריתם. המודל למד שיפוט אנושי והשתנה על בסיס חיזוקים חיוביים ושליליים. בעזרת כמה אלפי דוגמאות בלבד של שיפוט אנושי, דירוג התגובות, ה־AI החלה להפיק לכל השאילתות תשובות שדורגו גבוה. זה קרה גם בשאילתות שנדמו רחוקות מאלה שדירגו האנשים. איכשהו השיפוט האנושי לגבי איכות הכתיבה התפשט ברחבי המודל.

המעריכים למעשה פעלו כמהנדסי פונקציית תגמול. אך שלא כמו במודל סטטיסטי, שהפלט שלו יכול להרתיע רבים, מודלים גדולים של שפה מתקשרים בשפה פשוטה - כל מי שיודע לדבר או להקליד יכול להיות מהנדס פונקציית תגמול. הגילוי המדהים מאחורי ChatGPT היה שבמאמץ קטן יחסית מהנדסי פונקציית תגמול הצליחו לאמן מודלים גדולים של שפה להיות שימושיים ובטוחים. זו הדרך שבה OpenAI הצליחה להשיק מודל הפונה לצרכנים שלא סבל מהפגמים של קודמיו. הטמעת שיפוט אנושי במכונות הזניקה את ביצועי ה־AI. כעת הייתה למכונה היכולת לא רק לנבא רצפי מילים בסבירות גבוהה, אלא גם ליישם עליהם את השיפוט של מהנדסי פונקציית התגמול כך שיעניינו יותר את הקוראים.

בנוגע להחלטות רבות יהיה צורך במהנדסי פונקציות תגמול מיוחדים כדי להפעיל מכונות ניבוי מבוססות AI בקנה מידה גדול. גילוי הגישה האינטואיטיבית הזאת להטמעת שיפוט אנושי במכונות - כוונון עדין באמצעות למידת־חיזוק בעזרת משוב אנושי - עשוי לפתוח ל־AI הרבה יישומים רבי־ערך, שבהם השיפוט האנושי קשה להטמעה מראש אבל קל ליישום כשרואים אותו.

© Harvard Business School Publishing Corp

לתשומת לבכם: מערכת גלובס חותרת לשיח מגוון, ענייני ומכבד בהתאם ל

קוד האתי

המופיע

בדו"ח האמון

לפיו אנו פועלים. ביטויי אלימות, גזענות, הסתה או כל שיח בלתי הולם אחר מסוננים בצורה

אוטומטית ולא יפורסמו באתר.