"תעשיית ה-AI בישראל לא מודעת לגודל אירוע הרגולציה שמעבר לפינה"

בחזית ה-AI. על בינה מלאכותית ורגולציה / צילום: Shutterstock

אודות הפרויקט "בחזית ה-AI"

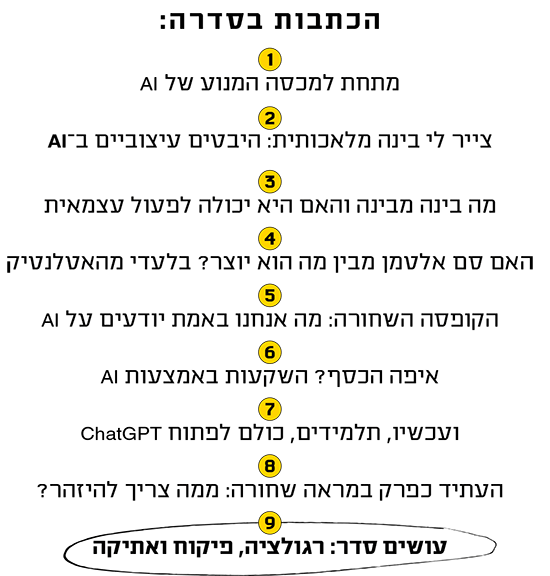

כולם מדברים על בינה מלאכותית, אבל כמה מאתנו באמת אימצו אותה לחייהם? בשבועות האחרונים יצאנו למסע בין כמה מהמוחות החריפים והמובילים בתחום, וביקשנו מהם לסייע לנו להרים את מכסה המנוע של הטכנולוגיה המהפכנית.

אנחנו שמחים להגיש לכם מסע בן עשרה פרקים אל רזי ה-AI, שבו נחקור את התופעה ובעיקר נמפה את ההיבטים היישומיים שלה. בכל שבוע נביא לכם פרק שעומד בפני עצמו, אך יש משמעות גדולה גם לאפקט המצטבר. בואו, יוצאים לדרך.

אמ;לק

בעולם כבר מאמצים רגולציה בתחום הבינה המלאכותית, כדי להגן כל המשתמשים והמידע שלהם וגם כדי למנוע שימוש לרעה ביישומים בעלי פוטנציאל מסוכן. אך ישראל בינתיים נותרת מאחור. "בהיעדר רגולציה חברות ישראליות עלולות למצוא עצמן ברשימות שחורות ובעייתיות", אומרת ד"ר תהילה שוורץ אלטשולר, עמיתה בכירה במכון הישראלי לדמוקרטיה ומומחית לסיכוני בינה מלאכותית.

לאזהרות מצטרפת ד"ר לימור זיו, מייסדת חברת Humane AI שמסבירה כי חברות ישראליות לא מודעות להשלכות הרגולציה האירופית החל מינואר 2024: "האחריות היא על החברות. עליהן להוכיח שהן נקטו את כל הפעולות כדי לצמצם סיכונים בטכנולוגיות שהן מפתחות או נסמכות עליהן".

לחלק מפעולות הזיהוי והאיתור של החטופים והחללים בשבועיים הראשונים של מלחמת חרבות ברזל אחראית הבינה המלאכותית. מוחות מבריקים גייסו כלים מתקדמים שיסייעו להבין מה עלה בגורלם ויקלו במעט על משפחותיהם. פלטפורמה בשם Swords of Steel למשל משמשת כמאגר מידע על נעדרים, חטופים וקורבנות, אותו ניתן להצליב עם מידע שמגיע מבתי החולים, הצבא והסרטונים שמשחרר החמאס.

הבינה המלאכותית גויסה גם למאמצי ההסברה. צ'טבוט בשם Iron Swords מנהל שיחות הסברה ומספק צילומים רלוונטיים ועדויות בכל שפה. יוזמות אחרות נעזרות ב-AI כדי לדובב דוברים בעלי שם בשלל שפות. כך, לדוגמה, נחשפתם לנועה תשבי, אורי גלר ואברי גלעד "מדברים" בשפות שהם אינם דוברים.

בכל יום אחר, לפני 7 באוקטובר, היינו מכנים את הכלים הללו Deepfake ומזהירים מהפוטנציאל המסוכן שלהם. טעימה קטנה מזה סיפק הקליפ של קולדפליי, אחת הלהקות המצליחות בעולם, שלכאורה שרה את "התקווה" מול קהל גדול ומריע במהלך הופעה באצטדיון. "תודה, קולדפליי, על התמיכה שלכם. ישראל אוהבת אתכם", כתב נוי אלוש, יצרן תכנים ויראליים ישראלי שהעלה את הסרטון, וצירף שלושה האשטגים, אחד מהם מעיד שמדובר ביצירת AI. אלא שרבים עדיין משוכנעים שקולדפליי תומכת בישראל.

עוד בסדרהלכל הכתבות

- החוקר שחושף: "זה מה שהביא להתפוצצות שאנחנו חווים עכשיו"

- יש לו קהילה עם 60 אלף חברים, והוא בטוח: זה סוף עידן הבינוניות

- חוקרים ביקשו מדמויות שנוצרו ב-ChatGPT לעשות מסיבה. כך זה נגמר

- האמנים שיצאו לקרב נגד הטכנולוגיה שבחזית

- איך הבינה המלאכותית עובדת? גם המדענים לא תמיד יודעים

- AI בעיני הון סיכון: איפה לשים את הכסף?

- בבית מדפיסים בתלת־ממד. אז למה בביה"ס חוזרים 200 שנה אחורה?

- מלוחמה פסיכולוגית ועד החלטה שהאנושות מפריעה לה: סכנות ה-AI

כמו תמיד, הבעיה איננה הטכנולוגיה, אלא מה שעושים איתה. בינה מלאכותית יכולה לאתר נעדר אך גם לשבש את דעת הקהל. זו הסיבה שרגולציה ומנגנוני שימוש אחראי חיוניים כל כך.

"עומק ורוחב שלא הכרנו"

ד"ר תהילה שוורץ אלטשולר, עמיתה בכירה במכון הישראלי לדמוקרטיה, היא מומחית בכל הנוגע לסיכוני הבינה המלאכותית. לא כי היא חובבת סכנות, אלא מפני שהיא פועלת כדי לדרבן את מקבלי ההחלטות בישראל להבין את הטכנולוגיה ולהיערך לקראתה.

ד''ר תהילה שוורץ אלטשולר / צילום: נורית יהלומי

ד"ר תהילה שוורץ אלטשולר (50)

אישי: נשואה + 3, גרה בירושלים

מקצועי: ראש התוכנית לדמוקרטיה בעידן המידע במכון הישראלי לדמוקרטי

"בישראל אנחנו בשלב המאני, וזה מסוכן", היא אומרת. "אנחנו מאמצים את הבינה המלאכותית ללא חקיקה מקדימה בבעיות שורש כמו סייבר, פרטיות ורשתות חברתיות, ואנחנו עלולים להטמיע מערכות מבלי להבין את הסכנות שלהן ומבלי ליצור מנגנוני הגנה. מלבד זאת, בהיעדר רגולציה חברות ישראליות עלולות למכור יישומים עם פוטנציאל מסוכן, נשק אוטונומי ללקוחות בעייתיים, כמו דיקטטורות, מה שיוביל אותן לרשימות שחורות ובעייתיות - כפי שקרה בסייבר, רק בסיכון ובעוצמה גבוהים פי 20".

לפני חודשים אחדים פרסמו שוורץ אלטשולר ועו"ד עמיר כהנא את הספר "אדם, מכונה, מדינה: לקראת אסדרה של בינה מלאכותית" (בהוצאת המכון הישראלי לדמוקרטיה), שפורט את סיכוני ה-AI ומסביר כיצד ניתן לגדר אותם מתוך הסתכלות גלובלית. "יש פה שני סיפורים של הבינה המלאכותית - כאיום גלובלי וכצורך ברגולציה פנימית - ושני הדברים הולכים יחד", אומרת שוורץ אלטשולר. "ענקיות הטכנולוגיה הגלובליות שמובילות בתחום שקולות למדינות מבחינת הכוח, הכסף והסוברניות, כי הן קובעות כללים ויכולות לחולל נזק".

במגרש הכוחות העולמי AI היא מטבע. "אם ארה"ב רוצה שסין לא תקבל שבבים היא צריכה לבקש טובה מדרום קוריאה, מיצרניות השבבים הגדולות בעולם; ואם טייוואן לא רוצה שסין תכבוש אותה רצוי שתהיה לה תעשיית שבבים כי אז המערב יגן עליה. אנחנו צריכים לנסות לדמיין את הנזקים שייגרמו. כל אחד יכול לשבת על ה-API של ChatGPT או קלוד והמודלים הגדולים ולייצר סוכנים אוטונומיים רבי־עוצמה, שעם חיבור לאינטרנט יכולים לעשות נזק עולמי, ודאי אם מי שעומד מאחוריהם הוא שחקן זדוני. כשנותנים ל־AI משימה היא תעשה כל מה שהיא יכולה כדי לממש אותה, תוך שהיא מפתחת סוג של מודעות עצמית: היא תדע היכן השרתים שלה וכיצד לחסום את גישת השימוש בה, ותחשוב על דרכים יצירתיות וחדשות למימוש מטרתה. בעקבות כך הנזק יהיה גלובלי, הרסני ואמיתי".

מה אפשר לעשות?

"יש לנו כמיהה לשקיפות, שיגלו לנו איך האלגוריתם עובד, כמו הנוסחה הסודית של קוקה־קולה. אבל זה לא יקרה כי אף אחד לא יודע, ולכן יש שתי אפשרויות: לאסור שימוש במערכות האלה, שגם פוגעות בזכויות של אנשים, או למצוא תחליפי שקיפות, כמו כלים סטטיסטיים".

הנה דוגמה מדירת שינה: בחור שחזר לארץ נעצר בנתב"ג, ושוטרים מצאו במזוודותיו סמים. כשהם שוחחו איתו הם גם הניחו שהוא הומו. "התברר שלמשטרה יש אלגוריתם שיוצר פרופילים של אנשים שחוזרים לארץ וממליץ את מי לעכב. איך הם קובעים את הרשימה? איך הסיקו שהוא גיי? אם הרשויות יגידו שמותר להן לפגוע בזכויות אדם באמצעות מערכות שלא ידוע איך הן עובדות - אנחנו בצרות".

הסיפור השני הוא ההטיות של מערכות ה-AI, שלא רק שאינן יוצרות עולם חדש וטוב, אלא מקצינות את ההטיות בעולם הנוכחי. "מה קורה כשמצלמות לא רק חושפות איפה היינו, מתי ועם מי, אלא גם אם אנחנו עייפים, כועסים או מה העדפתנו המינית? זו היכולת של מכונות להבין את הסודות שלנו מאלף מילים שכתבנו במדיה החברתית. האלגוריתמיקה יודעת להגיע לעומק ולרוחב שלא הכרנו לאורך ההיסטוריה".

להשתלב במגמות הרגולטוריות

כיצד הרגולציה תתמודד עם משימה כזו? נניח פה כמה עקרונות מנחים. למשל, לנוכח קצב ההתקדמות הגבוה של הטכנולוגיה צריך להסתכל על חקיקה באופן קצר טווח ודינמי, כך שחוק שיהיה בתוקף לשנה יעודכן בהמשך בהתאם לשינויים; או לסמן את הדברים המסוכנים ביותר שייאסרו, כמו בחקיקה האירופית. אלמנט נוסף הוא האוריינות הטכנולוגית של מקבלי ההחלטות ("מפחידה אותי הבורות הדיגיטלית שלהם", אומרת שוורץ אלטשולר) ועריכת ניסויים כדי לבדוק את השפעתן של טכנולוגיות חדשות.

כיום ישראל עוד לא משתלבת במגמות הרגולטוריות בעולם. בשנה שעברה האיחוד האירופי העביר את חוק הבינה המלאכותית, AI Act, שייכנס לתוקף ב־2024, ואפשר לצפות ל'אפקט בריסל' שראינו עם חקיקת חוקי הפרטיות (GDPR) ב־2018: כל מי שירצה לעבוד עם לקוחות אירופים, להשתמש בדאטה אירופית או לשתף פעולה עם חברה אירופית יצטרך לפעול על פי הכללים האלה. שוורץ אלטשולר חוששת מהאפקט ההפוך, אפקט ירושלים: "אצלנו אין חקיקה כזו. אם לא נפעל, נאבד את התאימות שלנו מול אירופה".

הרגולציה האירופית, שתיכנס לתוקף ב-2024 כאמור, אימצה נקודת מוצא מעניינת: היא יצרה ארבע קטגוריות המסווגות כל יישום AI, ולכל קטגוריה מגבלות, הנחיות וקנסות למי שיפרו אותן. "האחריות היא על החברות. עליהן להוכיח שהן נקטו את כל הפעולות כדי לצמצם סיכונים בטכנולוגיות שהן מפתחות או נסמכות עליהן, המשתמשים לא צריכים להוכיח שהם נפגעו", מסבירה ד"ר לימור זיו, מרצה ויועצת חדשנות טכנולוגית ובינה מלאכותית אחראית, מייסדת חברת Humane AI, המסייעת לחברות ישראליות שרוצות להתאים את עצמן לרגולציה האירופית, וחברת המועצה המדעית באגודה הישראלית לאתיקה בבינה מלאכותית (IAEAI).

ד''ר לימור זיו / צילום: תמי בר שי

ד"ר לימור זיו (41)

אישי: גרה בתל אביב

מקצועי: מרצה ויועצת חדשנות טכנולוגית ובינה מלאכותית אחראית, מייסדת Humane AI

זה חריג שחברות צריכות להוכיח את עצמן ולא המשתמשים.

"הרגולציה של האיחוד מתרכזת באדם. היא קודם כול רואה אותו ואת הזכויות שלו ומנסה ליצור מסגרת טכנולוגית שאנשים יוכלו לתת בה אמון. ניגשו שם לרגולציה מגישת ניהול סיכונים והם מחלקים את מערכות הבינה המלאכותית לארבע קטגוריות לפי רמות סיכון.

"הראשונה היא של Unacceptable Risk (סיכון בלתי מקובל) - מערכות מסוכנות באופן קיצוני שלא עומדות בקנה אחד עם ערכי היסוד האירופיים, כאלה שיוצרות נזק פסיכולוגי או מערכות מניפולטיביות שמשפיעות על ההתנהגות האנושית בצורה שאנחנו לא מבינים. אלה טכנולוגיות שאסור להשתמש בהן. הקטגוריה השנייה היא טכנולוגיות בסיכון גבוה, למשל אלה שקשורות לאשראי, תעסוקה, גיוס והערכת עובדים. הן כפופות לדרישות רגולטוריות מחמירות. הקטגוריה השלישית היא של סיכון מוגבל, וכוללת מערכות שבמגע עם צרכני קצה, כמו Generative AI (טכנולוגיה ג'נרטיבית). כאן חלה חובת שקיפות מיוחדת ואת צריכה לדעת אם את מתכתבת בצ'ט עם אדם או כלי שפה. הקטגוריה הרביעית היא מערכות בסיכון נמוך, שלא כפופות לדרישות רגולטוריות ספציפיות, אבל מומלץ שיאמצו כלים של אחריות ואתיקה".

מה הגישה הרווחת אצל חברות?

"מקסימום חדשנות במינימום סיכון. ברמת המוניטין חברות רוצות לומר שהן פועלות על פי הכללים, כלומר שהן רואות את טובת המשתמש. עם זאת, התעשייה בישראל אינה מספיק מודעת לגודל אירוע הרגולציה שמעבר לפינה".

לצייר מחשבות אנושיות

אלה ימי מלחמה, והרגולציה של הבינה המלאכותית אינה בראש סדר העדיפויות כרגע. אך היכן עמדנו ערב המלחמה? באוקטובר 2022 הממשלה פרסמה את עקרונות מדיניות הרגולציה ונאספו המלצות ממשרדי הממשלה. הגישה היא שכל משרד או רשות ממשלתית יפקחו על השימוש ב־AI בתחומם, מתוך הנחה שבכל תחום המאפיינים והסיכונים שונים. מעליהם יהיה מעין רגולטור־על שישמש כסמכות מקצועית.

כאמור, בשל ימי המלחמה אין לצפות כעת להמשך התהליך, אבל זה לא אומר שהצורך לא דוחק. ד"ר לימור זיו מתארת מחקר חדש שבו בינה מלאכותית קראה סריקות fMRI של אנשים. היא הצליחה לצייר באופן ריאליסטי את החפצים שהם ראו, או במילים אחרות: היא ציירה את מחשבותיהם, רעיון כמעט בלתי נסבל. "אנחנו קרובים ליום שבו בינה מלאכותית תפרש מחשבות ותתקשר איתן בלי לכתוב", היא אומרת. "בגלל שטכנולוגיה תמיד מוטה, האסדרה שתראה בנו בני אדם היא לטובת כולנו, המשתמשים והמפתחים".